Rechenzentren: Welche Tier-Klasse soll es sein?

Bild: © Erik Isakson / Getty Images

Um die Verfügbarkeit von Rechenzentren zu bestimmen, hat sich die Einstufung in Tier-Klassen durchgesetzt. Doch auch Faktoren wie Energieeffizienz und Standort haben maßgeblichen Einfluss auf die Qualität eines Datacenters. QSC bietet in ihren Rechenzentren in Hamburg, München und Nürnberg Serverraumfläche für alle gewünschten Verfügbarkeitsklassen an.

Der Begriff „TIER“ gehört zum Rechenzentrums-Basiswissen: Nach der Definition des US-amerikanischen Uptime-Institute lassen sich Rechenzentren in vier Qualitätsstufen (Tier) unterteilen, die wir in diesem Blog bereits ausführlich dargestellt haben. Zwischen Tier 1 mit einer Verfügbarkeit von 99,67 Prozent, was einer Ausfallzeit von maximal 28,8 Stunden im Jahr entspricht, und Tier 4 mit 99,99 Prozent und höchstens 26,3 Minuten jährlicher Fehlzeit liegen IT-technische Welten.

Qualität von Rechenzentren: Kaum noch Tier-1- und Tier-2-Installationen

In der Praxis spielen die Tier-Klassen 1 und 2 mittlerweile so gut wie keine Rolle mehr. Salopp gesprochen, reicht es für Tier 1 aus, einen Server an das Stromnetz anzuschließen und daneben einen Ventilator aufzustellen. In einem Tier 2 Data Center sind Stromversorgung und Klimatisierung redundant aufgebaut, verfügen aber nicht über getrennte Leitungswege. Fällt eine Leitung aus, stehen die Server still. Auch eine Wartung während des laufenden Betriebs ist nicht möglich.

Für Start-ups und kleinere Firmen mit nicht geschäftskritischen IT-Prozessen galten Tier 1 und Tier 2 lange als geeignet. Diese Empfehlung ist mittlerweile überholt. Heute beziehen solche Unternehmen Rechenzentrumsleistungen in der Regel aus der Cloud oder übergeben ihre Server an einen Colocation-Anbieter, der ihnen Verfügbarkeiten ab Tier 3 anbieten kann. Tier-2-Installationen finden sich vereinzelt noch in kleinen Kanzleien oder Arztpraxen. Im Betrieb mit Produktivdaten ist es jedoch nicht mehr üblich – die Ausnahme bilden kleine, spezialisierte Edge-Rechenzentren an den Rändern von Unternehmensnetzwerken.

Grundsätzlich ist daher von den Verfügbarkeitsklassen Tier 1 und Tier 2 eher abzuraten. Volle Redundanz und hohe Verfügbarkeit erreichen Unternehmen erst ab Tier 3 mit zwei Stromkabeln, die durch so genannte unterbrechungsfreie Stromversorgungen (USV) abgesichert sind. Zu beachten ist allerdings, dass die hohe Verfügbarkeit eines Rechenzentrums nicht gleichbedeutend ist mit einer ebenso hohen Verfügbarkeit von Applikationen und Services. Auf diesen Zusammenhang werden wir noch in einem separaten Folgebeitrag eingehen.

Tier 3 und 4: Anwendungsszenarien für hohe und höchste Verfügbarkeit

99,95 Prozent Verfügbarkeit im 24/7-Betrieb mit einer maximalen Ausfallzeit von rund vier Stunden im Jahr klingen sehr gut – allerdings sollte ein Server nie vier Stunden am Stück ausfallen. Daher ist es unbedingt notwendig, in den Kennzahlen zur Verfügbarkeit auch die maximal erlaubte Dauer eines einzelnen Ausfalls und die maximale Wiederherstellungszeit nach einem Ausfall festzulegen. Denn hohe Verfügbarkeiten ab Tier 3 sind grundsätzlich in Unternehmen mit geschäftskritischen IT- und Kundenprozessen gefordert, deren Mitarbeiter auf einen ständigen, auch mobilen Zugriff auf Unternehmensanwendungen angewiesen sind. Für Systeme wie etwa die Lohnbuchhaltung, die nur zu bestimmten Zeiten betriebsbereit sein müssen, kann eine Tier-3-Verfügbarkeit ausreichen.

Tier 4 hingegen ist von entscheidender Bedeutung für alle Anwendungen, die ununterbrochen hochverfügbar an einem Rechenzentrumsstandort laufen müssen. Dies betrifft beispielsweise die IT-gestützte Steuerung von Maschinen im Produktionsbetrieb – denn Produktionsausfälle sind gleichbedeutend mit Umsatzeinbußen. Auch Online-Dienstleister, deren Angebote rund um die Uhr abrufbar sein sollen, sind auf höchste Verfügbarkeit angewiesen. Dies gilt nicht nur für E-Commerce-Systeme von Handelsunternehmen, sondern auch für Gaming-Anbieter, deren Software immer häufiger nicht mehr lokal, sondern über die Server der Anbieter gespielt werden.

In aller Regel läuft der Rechenzentrumsbetrieb heute auf den Stufen Tier 3 und 4. So bietet die QSC AG in ihren zertifizierten und höchstverfügbaren Rechenzentren in Hamburg, München und Nürnberg auf 20.000 Quadratmeter Serverraumfläche für alle gewünschten Verfügbarkeitsklassen an.

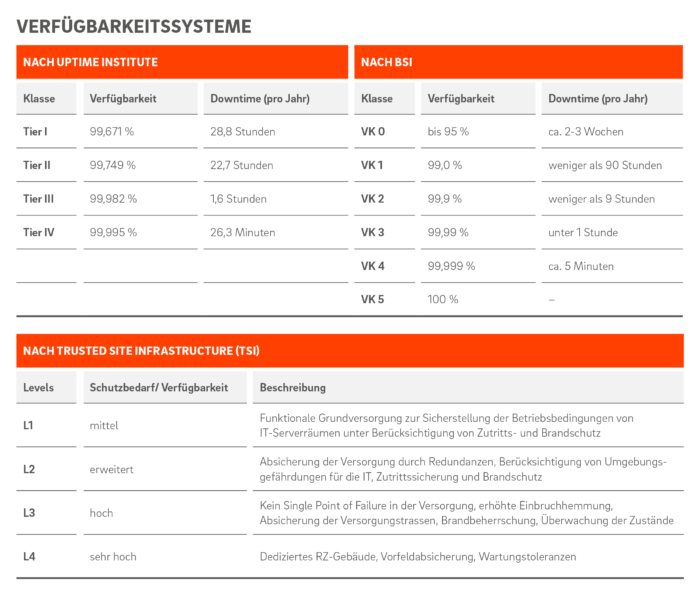

Unterschiedliche Systematik: Die Verfügbarkeit von Rechenzentren wird vom Uptime-Institute in Klassen gemessen und von TSI in Levels angegeben. Grafik: © QSC AG.

Europa-Norm für Rechenzentren geht über Tier-Klassifizierung hinaus

Die Klassifizierung von Verfügbarkeitsklassen nach der Definition des Uptime Institute hat sich weitgehend durchgesetzt. Als Zertifizierer spielt das Uptime-Institute, das Rechenzentren in den Phasen Design (Bauplanung), Bau und Betrieb zertifiziert, hierzulande allerdings kaum eine Rolle. Lediglich zwei Rechenzentren in Deutschland sind gemäß Uptime-Design zertifiziert.

Weitaus stärker verbreitet ist der Standard Trusted Site Infrastructure (TSI). Der Kriterienkatalog der TSI wurde von TÜV Informationstechnik (TÜViT) bereits 2001 entwickelt und berücksichtigt inzwischen auch die Anforderungen der neuen, europaweit geltenden Norm für Rechenzentren EN 50600. Die dort definierten vier Verfügbarkeitsklassen sind nahezu deckungsgleich mit Tier 1 bis 4:

- Verfügbarkeitsklasse 1: Geringe Verfügbarkeit. Auslegung ohne Redundanzen auf Basis eines Versorgungspfades

- Verfügbarkeitsklasse 2: Mittlere Verfügbarkeit. Auslegung mit Teilredundanzen auf Basis eines Versorgungspfades

- Verfügbarkeitsklasse 3: Hohe Verfügbarkeit. Auslegung mit redundanten Komponenten auf Basis von zwei Versorgungspfaden (aber nur ein Kälteversorgungpfad)

- Verfügbarkeitsklasse 4: Sehr hohe Verfügbarkeit. Auslegung mit Systemredundanzen auf Basis von zwei Versorgungspfaden (aber nur ein Kälteversorgungpfad)

Darüber hinaus definiert die Norm vier Schutzklassen, die die Eigenschaften von Räumen in Bezug auf Zutrittsschutz und Brandschutz sowie die Abwehr von inneren wie äußeren Gefahren beschreiben. Ein weiterer Faktor für die Bewertung der physischen Sicherheit ist der Standort eines Rechenzentrums und sein Abstand zu Tankstellen, Gasversorgern, chemischen Fabriken, Einflugschneisen, Hochwassergebieten und anderen potenziellen Risikofaktoren.

TÜViT hat auf die Nachfrage nach EN50600-Zertifizierungen reagiert und seinen TSI.Standard-Kriterienkatalog dementsprechend erweitert. Das Zertifikat TSI.EN50600 dokumentiert, dass ein geprüftes Rechenzentrum „konform zur EN 50600 ist, eine von vier Verfügbarkeitsklassen realisiert hat, mindestens die Schutzklassen 1-3 umgesetzt hat und die Energieeffizienzbefähigung nach einer von drei Granularitätsstufen aufweist“.

Energieeffizienz kontra Verfügbarkeit

Die neue europäische Norm reflektiert den steigenden Stellenwert der Energieeffizienz angesichts der immer höheren Wärmeleistungen in Serverschränken von bis zu 10 Kilowatt, die der Heizung eines Einfamilienhauses vergleichbar sind. Server mit solch hoher Leistung benötigen kontinuierliche Kühlung: Fallen ihre Kühlsysteme aus, droht nach rund einer halben Stunde der Ausfall der Server. Zudem kann die Raumtemperatur im Fall eines Defekts der Kühlsysteme schon nach einer knappen Viertelstunde auf 40 Grad Celsius klettern, was die Arbeit von Technikern extrem erschwert.

Die Wahl der Raumtemperatur ist von zentraler Bedeutung für das Verhältnis von Verfügbarkeit und Effizienz: Je wärmer ein Serverraum betrieben wird, desto weniger Strom muss für das Kühlsystem aufgewendet werden. Empfohlen wurde lange eine Raumtemperatur von 24 Grad Celsius. Heute möchten Unternehmen ihre Server im Rechenzentrum vermehrt mit höheren Raumtemperaturen von bis zu 30 Grad betreiben lassen. Damit verkleinert sich jedoch auch das Zeitfenster, um ausgefallene Kühlsysteme wieder anzuwerfen – erreicht die Raumtemperatur 50 Grad, versagen Server den Dienst. Mit anderen Worten: Was sie an Energieeffizienz gewinnen, verlieren Server an Verfügbarkeit.

So gleicht das Bestreben, Effizienz und Verfügbarkeit zu optimieren, der Quadratur des Kreises. Verfügbarkeit und Effizienz werden zu Gegenspielern. Die Frage nach dem goldenen Mittelweg stellt sich, angesichts der Kosten von Räumen und Stromzufuhr, für Colocation-Anbieter und Kunden gleichermaßen.

Weniger Bedarf an Höchstverfügbarkeit durch Hyperscaler?

Derzeit zeichnet sich bei Unternehmen eine Tendenz zum Verzicht auf Höchstverfügbarkeiten ab. Der Grund hierfür ist allerdings weniger das Bestreben nach mehr Energieeffizienz als vielmehr der Hyperscaler-Trend: Statt eine Anwendung mit Höchstverfügbarkeit an einem Rechenzentrumsstandort zu betreiben, läuft sie über viele dezentrale Serverinstanzen verteilt, die einfach skalierbar und sofort betriebsbereit sind. Neuere Anwendungen, etwa für die 5G-Infrastruktur, werden bereits dafür entwickelt, über mehrere Instanzen verteilt lauffähig zu sein. Wie sich Verfügbarkeit mit Hyperscalern neu definieren lässt, werden wir ausführlich in einem Folgebeitrag beleuchten.

Weitere Informationen:

- QSC-Rechenzentren: Zuverlässig wie ein Schweizer Uhrwerk (QSC-Blog)

- Georedundanz: QSC erfüllt BSI-Vorgaben für Rechenzentren (QSC-Blog)

- Tier-Klassen: Die vier Qualitätsstufen eines Rechenzentrums (QSC-Blog)

- Colocation Datacenter von QSC (QSC-Website)