Big Data: Was dahinter steckt

Daten sind das Öl des 21. Jahrhunderts, heißt es. Sie werden im Zuge der Big-Data-Revolution zu einem wichtigen Produktionsfaktor, vielleicht zum wichtigsten überhaupt. Die Herausforderung bei Big Data ist aber nicht die explosionsartige Zunahme der Datenmengen und der Datenvielfalt. Das eigentliche Problem ist: Wie lassen sich die Datenmassen intelligent analysieren und nutzen?

Neben Cloud Computing ist Big Data derzeit der am meisten gegoogelte Business-IT-Begriff. Die Suchergebnisse für „Big Data“ übertreffen sogar deutlich die für „Cloud“. 728 Millionen Einträge findet Google zum Begriff „Cloud“, gar 2,2 Milliarden zu „Big Data“ – also in etwa dreimal so viel. Big Data macht damit auch bei den Suchergebnissen seinem Namen alle Ehre und produziert auch hier riesige Datenmengen. Was aber ist dran an diesem schillernden Begriff, dass er die IT-Gemeinde so beschäftigt?

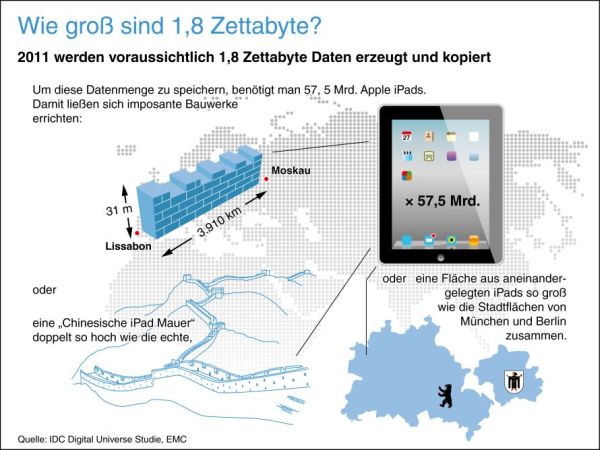

Diese IDC-Grafik veranschaulicht die Datenmassen und die Big-Data-Problematik. Die zugrunde liegende Studie erschien im Sommer 2011.

Die US-Firma EMC Corp. bietet Storage- und u.a. auch Big-Data-Lösungen an. In ihrem Auftrag erstellte IDC die “Digital Univers Studie”. Direkt zur Studie (pdf) kommen Sie per Klick auf das Logo.

Big Data – großen Daten(mengen) – ist zunächst nur ein Etikett, ein relativ inhaltsleerer Begriff. In der IT freilich hat er inzwischen so etwas wie einen Paradigmenwandel ausgelöst, der einen großen Teil Aufmerksamkeit auf sich zieht. Ausgangsbasis sind tatsächlich die zunehmenden Datenmassen, die die IT zu bewältigen hat, doch dahinter steckt wesentlich mehr als nur die schiere Menge an Daten.

Von Big Data spricht man, wenn das Volumen der Datenmengen in die Terabytes (1 Terabyte=1024 GB), Petabytes (1 Petabyte = 1024 Terabyte) und Exabytes (1 Exabyte = 1024 Petabyte) geht. Den Hintergrund bildet die Tatsache, dass die Datenmengen in den vergangenen Jahren förmlich explodiert sind. Laut einer Studie von IDC im Auftrag des Big-Data-Anbieters EMC durchbrach die Masse an digitalen Informationen, die pro Jahr erzeugt oder kopiert wird, im Jahr 2011 erstmals die Zettabyte-Barriere und ist auf auf 1,8 Zettabyte angeschwollen. Zettabyte ist die nächste Einheit nach Exabyte und entspricht einer Billion Gigabyte an Daten.

Damit ist die Informationsmenge in den letzten fünf Jahren laut IDC um den Faktor fünf gewachsen. Dass das keine theoretischen Größen sind zeigt die IDC-Studie Big Data in Deutschland 2012. Danach erwarten mehr als drei Viertel der deutschen Unternehmen in den nächsten zwei Jahren einen jährlichen Datenzuwachs von bis zu 25 Prozent. 13 Prozent rechnen gar damit, dass ihr Datenberg im selben Zeitraum um 25 bis 50 Prozent wächst.

Immer mehr Datenmassen

Warum die Datenmenge gerade seit einigen Jahren derart hochschnellen – dafür gibt es eine Reihe von Gründen. Hauptursache ist wohl die zunehmende Digitalisierung unserer Lebenswelten. Vor allem Maschinen und Rechner produzieren enorme Datenmengen: Eine moderne Jet-Maschine generiert heute beispielsweise in 30 Minuten bis zu 10 Terabyte an Daten. Bei 25.000 Flügen pro Tag entstehen durch eine solche Datenquelle Petabytes an Daten. Oder der Automobilbereich: Autohersteller gehen heute immer öfter dazu über, Crash-Tests auf Hochleistungsrechnern zu simulieren. Die dabei anfallenden Datenmengen sind gigantisch.

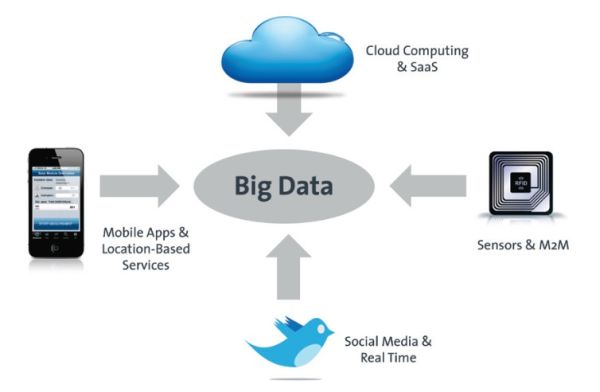

Auch neue Anwendungen fördern das Datenwachstum. Technologien wie Cloud Computing, RFID, transaktionale Systeme, Data Warehouses, Business Intelligence, Dokumenten-Management- und Enterprise-Content-Management-Systeme sind wichtige Technologien, die zu Big Data führen.

Business-Intelligence-Anwendungen beispielsweise werden sich künftig zunehmend auf Echtzeit-Daten stützen. Beispiele sind Autoversicherungstarife, die sich danach richten, wo der Autobesitzer gerade unterwegs ist, intelligente Stromnetzwerke, die die Energieerzeugung steuern, oder Werbebotschaften, die sich automatisch an das Feedback aus sozialen Netzwerken anpassen.

Den entscheidenden Anteil an der Datenexplosion aber haben das Internet, der zunehmende Anteil mobiler Geräte und vor allem Soziale Medien wie Facebook, Twitter und Co.

Nehmen wir als Beispiel Twitter. Millionen von Twitter-Usern tummeln sich hier, die mindestens einen Account haben und oft mehrmals täglich Tweets absetzen. Bei 140 Zeichen pro Tweet und bei der Geschwindigkeit, in der die Kurzmitteilungen abgesetzt werden, sorgt alleine Twitter pro Tag für mindestens acht Terabyte an Daten. An diesem Beispiel sieht man auch, dass nicht die Anbieter die Datenmengen erzeugen. Social Media Dienste wie Twitter lassen vielmehr ihre Daten erzeugen – von ihren Mitgliedern.

Die wichtigsten Quellen für die zunehmenden Datenmassen. Quelle: BITKOM / Experton Group – „Leitfaden Big Data im Praxiseinsatz“. Direkt zum Leitfaden (pdf) kommen Sie per Klick auf die Abbildung.

Immer mehr unstrukturierte Daten

Die schiere Menge ist aber nur ein Aspekt von Big Data. Der zweite, mindestens genauso wichtige ist eine Konsequenz oder Folge der Datenmengen: dass damit auch die Datenvielfalt zunimmt. Oft sind die Daten, wie sie heute bei den neuen Medien anfallen, unstrukturiert: Texte, Bilder, Audios oder Videos, wie sie vor allem im Social-Media-Umfeld entstehen. Angeblich sind bereits 85 Prozent der Daten nicht strukturiert.

Beides – die Datenmenge und die Datenvielfalt – stellt ein großes Problem für herkömmliche Datenbanken dar. In Unternehmen sind vorwiegend relationale Datenbanksysteme im Einsatz. Dies sind ist – simpel formuliert – Sammlungen von Tabellen, in denen einzelne Informationen in Datensätzen beziehungsweise Zeilen gespeichert sind.

Relationale Datenbanken sind ihrem Ursprung und ihrer Architektur nach dann effizient nutzbar, wenn sie für häufige Transaktionen auf Datensatzebene oder für Szenarien mit kleinen bis mittleren Datenvolumen eingesetzt werden. Zur Verarbeitung und Analyse von Datenmengen im Peta- oder gar Exabyte-Bereich sind sie nicht ausgerichetet. Vor allem aber lassen sich unstrukturierte Daten nicht oder nur mit Verrenkungen in die tabellenorientierten relationalen Datenbank-Systeme pressen.

Bei der Verarbeitung und Analyse von Big Data ist somit ein Umdenken in Bezug auf die Datenmanagementsysteme notwendig. Eine herkömmliche, relationale Datenbank wird bei steigenden Datenvolumina und zunehmender Datenvielfalt schnell an ihre Grenzen stoßen.

Verborgene Schätze heben

So lange diese Daten nur irgendwo abgelegt werden – seien sie auch noch so riesig oder noch so unstrukturiert oder beides – ist das Problem noch kaum relevant. Schwierig wird es, wenn aus den Daten Informationen gezogen werden sollen, wenn diese also „ausgewertet“ werden sollen. Das machen Untnernehmen und Wissenschaflter ja eigentlich schon immer. In Daten Regelmäßigkeiten, Gesetze, Muster erkennen.

In den letzen Jahrzehnten haben besonders Wirtschaftsunternehmen erkannt, dass man aus Daten Geld machen kann. Denn in den Datenbergen stecken Schätze, die man nur heben muss. Je mehr man über seine Kunden weiß, umso besser kann man Services und Produkte auf diese zuschneiden. Beispielsweise wollen Unternehmen Stimmungen oder Produkt- und Firmennamen in Social Networks aufspüren. Oder durch Auswertung von Kundenkommentaren Vorschläge für die Verbesserung von Produkten gewinnen. Oder einfach ihr Business verbessern.

Vor allem aber braucht es für Unternehmensleitung und Manager, die strategisch wichtige Entscheidungen treffen müssen, immer auch die Hilfe von Daten. Laut einer Capgemini-Studie bestätigen heute zwei Drittel der Führungskräfte, dass Daten in ihrem Unternehmen einen hohen Stellenwert haben. Datenerhebung und -analyse lägen ihrer Unternehmensstrategie und der täglichen Entscheidungsfindung zu Grunde.

Immer seltener werden dagegen Führungskräfte, die sich bei Entscheidungen einzig auf ihre Erfahrungen und ihre Intuition stützen. Gut die Hälfte der Befragten hat den Eindruck, dass Managemententscheidungen, die auf dem Bauchgefühl oder Erfahrungswerten beruhen, mehr und mehr als unseriös empfunden werden.

Wichtig für die Entscheidungsfindung werden dabei laut Studie immer häufiger auch Social-Media-Inhalte – so die Einschätzung von mehr als 40 Prozent der Studienteilnehmer. Dies gilt insbesondere für den Handel, die Konsumgüter- und die produzierende Industrie sowie für das Gesundheitswesen und pharmazeutische Unternehmen.

„Die Ansätze rund um Big Data kommen einem Quantensprung in der Unterstützung geschäftlicher Entscheidungen gleich“, so Rüdiger Eberlein, Experte für Business Information Management (BIM) beim Analystenhaus Capgemini. „Der Wettbewerbsvorteil entsteht einerseits durch die Einbeziehung vieler neuer Datenquellen – Stichwort: Social Media –, andererseits durch die schnelle und effiziente Analyse von Daten. So können Entscheider rasch auf Veränderungen im Markt und im Kundenverhalten reagieren.“

Erwarteter Business-Nutzen aus dem Einsatz von Big Data in deutschen Unternehmen. Quelle: BITKOM / Experton Group. Zum Vergrößern bitte Grafik anklicken.

Was daraus folgt

In der Vergangenheit hat die Analyse von Geschäftsdaten vergleichsweise gut funktioniert. Strukturierte Daten, meist in relationalen Datenbanken abgelegt, und darauf basierende Statistik- und Analyse-Tools machten das problemlos möglich. Doch wie soll man Datenanalysen bei unstrukturierten, großen Datenmengen bei Größenordnungen von Petabyte und Exabyte behandlen? Es braucht neue, ganz andere Ansätze um mit Big Data umzugehen.

Zusammengefasst sollte klar geworden sein, dass die Big Data Problematik aus drei Facetten oder Problembereichen besteht. Da ist zum ersten das Problem der zunehmenden Datenmassen, zweitens gibt es immer mehr unstrukturierte Daten und drittens stellt sich die Herausforderung, aus diesem „Big Data“ ökonomisch relevante Informationen zu extrahieren.

Der BITKOM gibt in seinem lesenswerten Big-Data-Leitfaden eine Definition von Big Data, die diese drei Aspekte gut widerspiegelt: „Big Data bezeichnet die wirtschaftlich sinnvolle Gewinnung und Nutzung entscheidungsrelevanter Erkenntnisse aus qualitativ vielfältigen und unterschiedlich strukturierten Informationen, die einem schnellen Wandel unterliegen und in bisher ungekanntem Umfang anfallen“. Dazu stellt Big Data „Konzepte, Methoden, Technologien, IT-Architekturen sowie Tools zur Verfügung, um die geradezu exponentiell steigenden Volumina vielfältiger Informationen in besser fundierte und zeitnahe Management-Entscheidungen umzusetzen und so die Innovations-und Wettbewerbsfähigkeit von Unternehmen zu verbessern“.

Unsere Big-Data-Serie im Überblick:

- Big Data: Was dahinter steckt

- Was kann Big Data?

- Revolution oder Evolution: Wie Big Data die IT verändert

- Big Data: Teile und herrsche mit Hadoop

Lesen Sie auch die Artikelserien von Klaus Manhart auf dem QSC-Blog zu…