Multitouch, Sprache, Blickkontakt: Das Ende der Tastatur?

Die Zeit der Tasten und Knöpfe scheint sich langsam dem Ende zuzuneigen. Heute bedienen Menschen ihre Smartphones, Tablets und zunehmend ganz normale PCs mit Wischen, Fingerzeig und Sprache. Dabei sind Multitouch-Bedienung und Sprachbefehle nur der Anfang. Künftig wird die klassische Tastatur immer mehr zu Nebensache – auch am Arbeitsplatz.

Eine besonders ausgefeilte Form von berührungsloser Gestensteuerung demonstrierte 2002 der Spielberg-Film Minority-Report. Quelle: 20th Century Fox.

Technologie muss sich dem Menschen anpassen – nicht umgekehrt. Das war einer der Leitsätze von Apple-Gründer Steve Jobs. In diesem Sinne ist in den PC-Urzeiten die Steuerung durch die Maus entstanden. Derselbe Geist spiegelt sich nun in der Bedienung von Geräten über direkte Fingerberührungen und Gesten wider. Bei beidem hat Apple eine Pionierrolle gespielt.

Mit dem iPhone und dem iPad hat sich in wenigen Jahren die Art und Weise, wie man Mobilgeräte bedient, radikal verändert.

Tasten an Smartphones sind heute inzwischen so gut wie verschwunden, gesteuert wird mit Multitouch und Fingerzeig. Kapazitive und optische Touchscreens erkennen gleichzeitig mehrere Berührungen mit den Fingern und ermöglichen eine intuitive Bedienung, die perfekt mit den modernen Kommunikationsgeräten harmoniert.

Auch die Wiederentdeckung der Steuerung via Sprache kann sich Apple zu Gute halten. Der Sprachassistent Siri, Bestandteil des aktuellen iPhone 4S, ermöglicht es in natürlicher Sprache Befehle ans Handy geben. Dass die Technik derzeit noch in den Kinderschuhen steckt, merkt man deutlich, besonders in der deutschen Variante.

Doch das dürften nur Anfangsprobleme sein. In vielen Bereichen funktioniert die Spracherkennung schon seit einiger Zeit relativ gut. So etwa beim Diktieren. Bei Juristen und Ärzten ist die gesprochene Texterfassung schon länger verbreitet. Und sie kann deutlich effizienter sein als herkömmliches Tippen, wie das Bürgerbüro der dänischen Gemeinde Fredericia beweist. Dort wird nicht mehr getippt, sondern gesprochen.

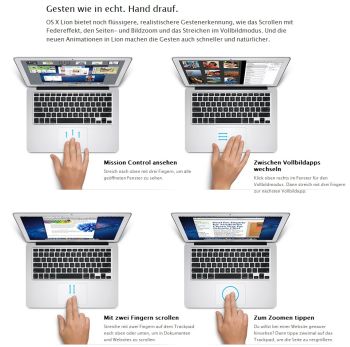

Multitouch-Gesten erobern auch die Trackpads von Notebooks, wie diese Apple-Seite zeigt. Zur Vergrößerung bitte das Foto anklicken. Foto: Apple.

Die Mitarbeiter der öffentlichen Verwaltung sind mehrheitlich der Meinung, dass sich dadurch die Qualität ihres Arbeitsplatzes verbessert hat. Im Durchschnitt schaffen die Angestellten beim Erstellen von Schriftstücken jetzt mehr als 200 Wörter in der Minute – gegenüber knapp 60 Wörtern beim Schreiben an der Tastatur.

Gesten- und Sprachsteuerung greift um sich

Mit der praktischen Steuerung per Gestik und Sprache hat Apple zweifellos eine kleine Revolution ausgelöst. Beide Bedienkonzepte greifen derzeit auf alle möglichen Geräte über, und ein Ende ist nicht abzusehen. So kommen immer mehr All-in-one-PCs mit berührungsempfindlichen Displays daher, und selbst Multifunktionsdrucker lassen sich betatschen – ein eher zweifelhafter Fortschritt.

Sinnvoll erscheinen Touch-Displays bei den neuen Ultrabooks, wie es Intel plant, wobei Tastatur und Trackpad erhalten bleiben. Was man benutzt, hängt von der Anwendung ab. Laut Intel hätten Tests gezeigt, dass berührungsempfindliche Displays an Klapprechnern überraschend gut ankommen.

Multitouch-Steuerung am All-in-one-PC. Foto: Lenovo.

Auch die angekündigte Sprachsteuerung – ähnlich Siri im iPhone – macht bei Ultrabooks Sinn. Die Software von Dragon soll aber anders als beim iPhone nicht in der Cloud arbeiten. Weil Ultrabooks leistungsfähiger sind, kann die Auswertung der Sprachbefehle direkt auf dem Rechner erfolgen. Sie funktioniert also auch offline.

Intel experimentiert außerdem mit neuen Formfaktoren für mobile Computer. Dazu gehören „Convertables“ wie es Intel-Vize Eden nannte. Bei diesen Rechnern verschwindet die Tastatur auf Wunsch unter einem drehbaren Display. Das Ultrabook wird zum Tablet.

Studien darüber, ob dieser Mix aus Gesten-, Sprach- , Maus- und Tastatursteuerung tatsächlich Arbeitsprozesse effizienter macht oder den Anwender eher verwirrt zurücklässt, gibt es derzeit noch nicht.

Mit den Augen steuern

Während Gestik und Sprache gewisse Erfolge bei der Gerätesteuerung vorweisen können, steckt die Steuerung per Blickkontakt aus praktischer Sicht noch in den Kinderschuhen. Dennoch: Erste Geräte mit rudimentärer Blicksteuerung sind schon im Einsatz. Im Anfang Mai vorgestellten „iPhone-Jäger“ Galaxy S3 von Samsung erkennt die Kamera an der Bildschirmseite, wenn die Augen des Benutzers auf das Telefon gerichtet sind. Ist es der Besitzer, erwacht das Smartphone automatisch aus dem Schlafmodus. Und wenn die Kamera erkennt, dass der Bildschirm nicht mehr betrachtet wird, geht er aus. Zugegeben noch elementar, aber ein erster Anfang.

Das neue Samsung Galaxy S3 lässt sich per Multitouch, Sprache und – via Eye Tracking Software – auch über Blickkontakt steuern. Foto: Samsung.

Künftig kann die Steuerung per Blick zur normalen Computerbedienung eingesetzt werden, behauptet zumindest Craig Mundie, Forschungsdirektor bei Microsoft. Er präsentierte den Prototypen eines transparenten Glas-Displays, das auf Blicke und Augenbewegungen reagiert. Die Navigation, so Mundie, werde leichter, Inhalte können schneller überflogen werden und Scrollen und Umblättern gehören der Vergangenheit an.

Doch zurück zur Gestensteuerung: Eine besonders ausgefeilte und natürliche Form von berührungsloser Gestensteuerung zeigt 2002 der Spielberg-Film Minority-Report. Darin wischt Tom Cruise mit großen Gesten durch die Luft und kontrolliert damit riesige, transparente Benutzeroberflächen, die vor ihm schweben. Diese berührungslose Steuerung in der dritten Dimension lässt sich ebenfalls schon heute einsetzen.

Realisierte Science-Fiction

Das deutsche Unternehmen Ident Technology hat einen Chip entwickelt, der diese Science Fiction realisiert und natürliche und intuitive Gesten des Nutzers erkennt. Sowohl direkte Berührungen des Gerätes, als auch komplexe Gesten und dynamische Positionsbestimmungen der Hand im dreidimensionalen Raum vor dem Gerät werden in verarbeitete Eingabebefehle übersetzt. Genutzt wird dabei die Tatsache, dass sich ein elektrisches Feld ändert, sobald sich ihm ein anderes Objekt nähert.

Craig Mundie, Forschungsdirektor bei Microsoft, präsentierte den Prototypen eines transparenten Glas-Displays, das auf Blicke und Augenbewegungen reagiert. Foto: Microsoft.

Werden künftig also Menschen an ihren Arbeitsplätzen sitzen und wild gestikulierend und in einem babylonischen Sprachenwirrwarr ihre Arbeit verrichten? Wohl nicht. Jedes Bedienkonzept hat seine Stärken und wird in spezifischen Bereichen eingesetzt. Wir werden das gerade nutzen, was uns am adäquatesten und natürlichsten erscheint.

„Die Vision ist eine sogenannte implizite Mensch-Technik-Interaktion, bei der wir uns keine großen Gedanken mehr machen müssen, wie etwas zu bedienen ist“, sagte Matthias Peissner, Leiter einer Fraunhofer Arbeitsgruppe für die Mensch-Maschine-Interaktion, in der Stuttgarter Zeitung. „Unsere natürlichen Verhaltensweisen wie Gesten, Blicke und Sprachäußerungen werden erkannt und intelligent interpretiert. Wir müssen bei der Gestaltung neuer technischer Produkte sehr genau die Bedürfnisse und Vorbehalte der zukünftigen Nutzer verstehen. Denn letztlich wird sich nicht alles durchsetzen, nur weil es technisch möglich ist.“

Artikel-Serie über Trends in der Arbeitswelt

Dieser Beitrag ist der zehnte Teil einer Serie über Trends in der Arbeitswelt, die der Münchener Wissenschaftsjournalist Dr. Klaus Manhart exklusiv für das QSC-Blog verfasst: Wie werden wir in Zukunft arbeiten, wie verändern moderne IT-Services und TK-Anwendungen unseren Büroalltag? Und welche neuen Möglichkeiten der Zusammenarbeit über Unternehmensgrenzen hinaus ergeben sich dadurch künftig? Bisher veröffentlicht:

- 1. Wie Cloud-Services die Arbeitseffizienz steigern werden

- 2. Die Ablösung des PCs – Wie iPad & Co. den Arbeitsplatz verändern

- 3. Thin Clients: Schlank statt fett

- 4. Virtualisierung auf dem Vormarsch

- 5. Breitbandtechniken heute und künftig

- 6. Effizienter arbeiten mit Unified Communications

- 7. Soziale Netzwerke – Das Arbeitsgerüst der Zukunft

- 8. Bring your own Device – IT-Demokratie am Arbeitsplatz

- 9. Virtuelle Teams: Grenzenlos arbeiten

- 10. Multitouch, Sprache, Blickkontakt: Das Ende der Tastatur?

- 11. Kollege Roboter – Das Personal der Zukunft

- 12. Arbeitsplatz der Zukunft: Was Unternehmen erwarten und Arbeitnehmer glauben

Kommentare

Dieser philosphie mit realisierbaren lösungen verfolgt Hmi-tec lalk joachim